各製品の資料を入手。

詳細はこちら →

Apache Spark JDBC Driver を使って、あらゆるJDBC 対応のアプリケーション・ツールからリアルタイムApache Spark SQL データにデータ連携できます。 ドライバーによってRDB データソースのODBC と同じ感覚で、Apache Spark SQL にSQL でデータ連携が可能になります。 CData ドライバーは単体で機能し、追加のソフトウェアのインストールは不要です。

機能紹介

- Spark SQL にSQL をマッピングし、Apache Spark へのSQL-92 クエリを実現

- DataBricks Enterprise Platform に互換

- Apache Spark SQL NoSQL データへのSQL-92 でのクエリを実現。

- フレキシブルなNoSQL のフラット化 - 自動スキーマ生成、フレキシブルなクエリなど。

- Apache Spark SQL データにリアルタイムアクセス

- BI、帳票、ETL ツールやカスタムアプリへのシームレスなデータ連携

- データ集計、複雑なJOIN クエリなどのSQL をフルサポート

スペック

- 標準JDBC インターフェースでApache Spark にデータバインド。

- 標準SQL とSpark SQL をマッピングして、SQL-92 で直接Apache Spark にアクセス。

- データ、パラメータ、& メタデータでUnicode をフルサポート。

- 32-bit、64-bit オペレーティングシステムをサポート

機能・特徴

-

Pure Java タイプ 4/5* 準拠のドライバー

Java アーキテクチャ完全準拠で、クライアント側のライブラリに依存しないネイティブプロトコルを実現します。

* CData ドライバーはタイプ5ドライバーの定義を満たします(正式にはJDBCは4タイプ)。 -

All-In-One 配布

JDBC 3.0、JDBC 4.0要件、およびJVM 1.5版を満たすシングルJAR。

-

互換性認証済み*

CData ドライバーは広範囲な水準のテストを行っているほか、SAP Crystal Reports、Pentaho、Business Objects、Crystal Reports などの業界トップクラスのアナリティクス・帳票ツールから互換性認証を受けています。

* こちらから ナレッジベース how-to 記事をご覧ください。 -

メタデータ検出

JDBC DatabaseMetaData をフルサポートし、拡張可能なスキーマ検出機能を有します。ユーザー権限に即したテーブル、カラム、キー、や他のデータ定義を生成します。

-

主要なIDE に統合

Eclipse、IntelliJ、NetBeans などの主要なJava IDE をデザインタイムでサポート。

-

JDBC リモーティング

CData のリモーティング機能を使って、異なるプラットフォーム(Java、.NET、C++、PHP、Python、etc.)のさまざまなクライアントからの接続(ODBC、JDBC など)が可能なJDBC 接続をホストすることができます。JDBC リモーティングにより、MySQL ワイヤプロトコルサーバーが利用できます。

-

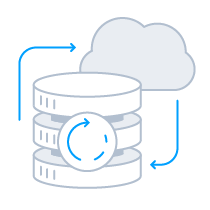

レプリケーションとキャッシング

CData のレプリケーションやキャッシングコマンドにより、簡単にローカルおよびクラウドデータストア(Oracle、SQL Server、Google Cloud SQL、etc.)へのデータのコピーができます。レプリケーションコマンドはインテリジェントな差分更新によるデータのキャッシュを行う機能を備えています。

-

文字列型、日付型、数値型のSQL 関数群

CData ドライバーは50以上の関数ライブラリを持ち、カラムと出力フォーマットを操作します。代表的な例では正規表現、JSON、およびXML 処理機能があります。

-

コラボラティブクエリ処理

CData ドライバーはクライアント側における追加処理を実現することにより、接続するデータソースの機能を高め、SUM、AVG、MAX、MIN などの分析集計を可能にします。

-

容易なスキーマのカスタマイズ

JDBC ドライバーのデータモデルはテーブル / カラムの追加や削除、データ型の変更などのカスタマイズが簡単に行えます。追加ビルドは不要です。カスタマイズは、human-readable スキーマを使ってランタイムで編集ができます。

-

セキュアな接続

すべてのクライアント - サーバー間接続において、TLS / SSL データ暗号化などのエンタープライズレベルのセキュリティ機能が備わっています。

JDBC Driver パフォーマンス

伝統的なリモートアクセスのアプローチでは、パフォーマンスがアプリケーションのボトルネックです。アプリケーションが社内利用であれ、商用であれ、ウェブやモバイルアプリケーションであれ、スローなパフォーマンスはプロジェクトの成功を妨げます。リモートソースにアクセスすること自体がパフォーマンス悪化の問題をはらんでいるのです。以下は代表的な問題です。

- ネットワーク接続 - モバイルアプリケーションでよくある、スローなネットワーク接続や遅延の問題。

- サービスの遅れ - サーバー側のハードウェアやソフトウェアの更新によるサービスの中断がもたらす遅れ。

- 大容量データ - 大容量データの意図的な、もしくは意図しない要求。

- 切断 - ネットワーク接続の切断。

CData JDBC Driver for Apache Spark のパワフルなスマートキャッシング技術を使って、パフォーマンスを大幅に向上させアプリケーションのボトルネックを解消できます。

スマートキャッシング

スマートキャッシングをオプションとして設定可能です。クエリされたデータをローカルデータベースにソートできます。スマートキャッシングを有効にすると、パーシスタントなローカルキャッシュデータベースが作成され、リモートソースから取得したデータのレプリカが保持されます。小さく軽量で高速なキャッシュデータベースは、パーシスタントストレージとして複数の接続が可能です。

JDBC Driver を使ったキャッシュは、以下を含む多くのオプションにより柔軟な設定ができます。

- オートキャッシュ - すべての要求に対し、自動でデータのローカルキャッシュを保持。CData プロバイダーを使うと、SELECT クエリを実行するたびに自動的にデータをキャッシュデータベースにロードします。クエリで返された各行は、必要に応じてキャッシュデータベースの対応するテーブルに挿入および更新されます。

- エクスプリシットキャッシュ - オンデマンドでのキャッシュ。格納するデータとそれを更新するタイミングを細かく設定できます。エクスプリシットキャッシュでCACHE ステートメントを明示的に実行すると、キャッシュコンテンツをフルコントロールできます。

- ノーキャッシュ - すべての要求はライブデータにのみアクセスし、ローカルキャッシュファイルは作成されません。

このパワフルなキャッシング機能を使うとアプリケーションのパフォーマンスを向上し、オフラインでもアプリケーションの一部機能を継続的に利用できます。ローカルストレージや、データのシリアライゼーション / デシリアライゼーションのためのコーディングは不要です。

JDBC Driver のキャッシングに関する情報およびベストプラクティスは、ヘルプファイルをご覧ください。

エンタープライズレベルのリモーティング

Apache Spark SQL データのMySQL / SQL エントリーポイント

CData JDBC ドライバーには完全に統合されたパワフルなリモーティング機能が備わっており、バーチャルにどこからでもApache Spark SQL にアクセスできます。CData ドライバーは、インカミングSQL およびMySQL クライアント接続の受容と、データベースの標準リクエストへのサービスのオプション機能を備えています。

CData JDBC ドライバーを使って、SQL Server またはMySQL をサポートするあらゆるクライアントからApache Spark SQL データに連携できます。ウェブやモバイルアプリケーションからCRM、CMS システム、SQL Server Analysis Services のようなBI ツール、さらにはMySQL Workbench のような馴染みのあるマネージメントアプリケーションなどでの連携が可能です。

- 外部データにアクセスできるいかなるアプリケーションからでも、Apache Spark SQL にバーチャルにアクセスします。SQL Server またはMySQL データにアクセスできるアプリケーションであれば、このドライバーを使ってApache Spark SQL に接続できます。

- Apache Spark SQL をSQL Server Analysis Services のような馴染みのあるBI ツールに接続できます。

- SQL リンクサーバー接続経由で、エンタープライズApache Spark SQL 統合を実現します。

- リモートデータベース接続の業界標準であるMySQL およびSQL (TDS) リモートアクセスプロトコルをサポートしています。

- リモート接続には高度なワイヤプロトコル SSL セキュリティを提供しています。

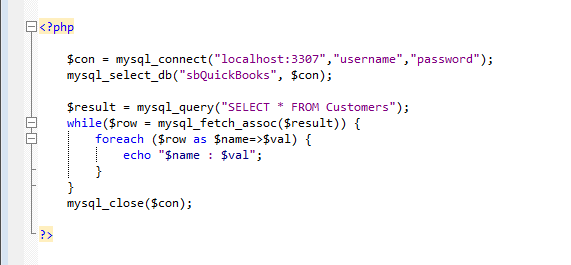

コーディングによるApache Spark SQL データへの接続

Spark ドライバーはSQL Server またはMySQL の標準インターフェースを備え、データの読み出し / 書き込み(CRUD)をサポートします。どのソリューションアーキテクチャであっても、このパワフルなリモーティング機能を使ってアプリケーションを簡単にApache Spark SQL に接続できます。

標準的なクライアントライブラリの一つを使ってNET、Java、PHP、Python、Ruby、Objective-C、etc. からSQL / MySQL にアクセスし、Spark への統合を始めましょう。

エンタープライズレベルのJDBC 接続

Apache Spark JDBC Driver を使って、Java / J2EE アプリケーションから簡単に Spark にデータ連携することができます。RDB へのアクセスと同じ感覚で、Apache Spark Driver を使うだけでデータに標準SQL でアクセス。CData ドライバーは単体で機能し、追加のソフトウェアのインストールは不要です。

- さまざまなツールを使ってSpark にアクセス。JDBC インターフェースを使って、Java ベースのアプリケーションおよび開発テクノロジーからSpark にアクセス可能です。

- リモート接続の高度なワイヤプロトコルSSL セキュリティ。

- アプリケーションの配布および設定の高速化。

BI、ETL、帳票ツールからSpark に接続

JDBC はJava ベースのアプリケーションをデータに接続するためのインターフェースで、幅広くサポートされています。多くのBI、帳票、ETL、データベース、およびアナリティクスツールが、JDBC 接続でデータの読み書きを行う機能を備えています。

- DBeaver

- DbVisualizer

- IntelliJ

- DataSpider

- AWS Glue

- UnitBase

- Databricks

- Apache Spark

- Apache Nifi

- Apache Tomcat

- Cloud Data Fusion

- Mendix

- JasperSoft Studio

- KNIME

- JBoss

- Apache Camel

- R

- Neuron

- Apache Solr

- Crystal Reports

- Denodo

- Actionista!

- QuickSolution

- その他多数のツールに対応

Apache Spark Driver により、標準準拠のJava JDBC ドライバーでSpark サービスに複雑な操作なしにデータ連携ができます。アプリケーションからApache Spark Driver を通じてシンプルなTransact-SQLを使い、Spark にアクセスします。

CData JDBC Driver for Apache Spark はデータ連携の問題を解決し、パワフルなセキュリティ機能、スマートキャッシング、バッチ処理、ソケットマネジメントなどを実現します。

Spark アプリケーション統合

Apache Spark Driver はConnection、Statement、ResultSet を含む、MySQL やOLEDB 向けのJDBC ドライバーと同じJDBC アーキテクチャを有します。そのため、Spark データに使い慣れた方法で連携できます。Apache Spark Driver は標準的なIDE(Eclipse、IntelliJ、NetBeans、etc.)で利用できます。馴染みのあるクラスでのコーディングや、Swing やEclipse SWT Widgets などのデータコントロールから利用できます。

例:

Connection conn =

DriverManager.getConnection("jdbc:spark:user=myuseraccount;password=mypassword;");

boolean ret = stat.execute("SELECT * FROM ApacheSpark");

ResultSet rs=stat.getResultSet();

while(rs.next()){

for(int i=1;i<=rs.getMetaData().getColumnCount();i++)

{

System.out.println(rs.getMetaData().getColumnName(i) +"="+rs.getString(i));

}

}

双方向連携:CRUD をフルサポート

Apache Spark Driver はRead-only 機能にとどまらず、CRUD 処理(作成、取得、更新、削除)をフルサポートしています。アプリケーションのエンドユーザーはRDB を利用するように、Apache Spark Driver が表示するデータを簡単に活用できます。

Connection conn =

DriverManager.getConnection("jdbc:spark:user=myuseraccount;password=mypassword;");

String query = "UPDATE ApacheSpark SET Where= ...";

PreparedStatement pstmt = conn.prepareStatement(query);

pstmt.setString(1, "Location");

pstmt.setString(2, "UID");

pstmt.execute();

int count=pstmt.getUpdateCount();

JDBC の動画コンテンツ